Mit dem Ziel, möglichst kleine, mobile Systeme zu erschaffen, die auf mikroskopischer Ebene Gegenstände manipulieren können, wurde an der University of Waterloo in Ontario, Kanada, ein microbot entwickelt.

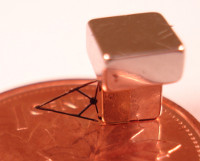

Der Roboter ist nur wenige Millimeter groß, wie der nebenstehende Größenvergleich mit einem kanadischen Penny zeigt. Der Roboter kann außerdem fliegen (schweben), angetrieben von einem äußeren, magnetischen Feld.

Der microbot besteht aus einem Permanentmagneten und einem Miniatur-Greifer (der Ausleger, im Bild und im Video links). Der Greifer kann geöffnet werden, indem der Roboter durch einen externen Laser beschossen und damit erhitzt wird.

Der Trick ist, dass der Roboter damit keine Energiequelle mit sich führen muss, da sowohl für die Fortbewegung als auch für die Aktorik die Energie von außen kommt. Da der Roboter außerdem keine Sensorik direkt mit sich trägt, konnte er kleiner als bisherige microbots gebaut werden.

Da keine Kabel nötig sind und der Roboter frei schwebt, kann er in einer abgeschlossenen Umgebung operieren, während der ganze Aufbau außerhalb ist. Er kann damit auch in gefährlichen und toxischen Umgebungen operieren. Da er außerdem über keine mechanischen Kupplungen verfügt, operiert er staubfrei und ist damit auch für den Einsatz in Reinräumen geeignet.

News der University of Waterloo.