Wer hat sich nicht schon einmal einen Roboter gewünscht, der im Haushalt hilft? Der zum Beispiel schon einmal den Kuchenteig anrührt, knetet und ausrollt, während man selbst die Glasur vorbereitet, bzw. einem das lästige Gemüseschnibbeln beim Kochen abnimmt. Oder einen kleinen Roboterassistenten, der einem bei heimischen Bastelarbeiten die richtigen Werkzeuge anreicht, wie man es aus OP-Sälen in Krankenhäusern kennt: „Roboter, Schraubenzieher!“ – „Schraubenzieher, und weiter?“ – „Schraubenzieher, bitte!“

Zumindest in Industrieszenarien ist das keine allzu weit entfernte Zukunftsvision mehr. Flexibel anpassbare Roboter, die autonom oder Hand in Hand mit dem Menschen in einer Werkstatt oder Produktionsstrasse arbeiten und diesen bei Fertigungsaufgaben unterstützen, sind schon seit geraumer Zeit ein strategisches Anliegen europäischer Wissenschaftler und der Robotikindustrie. So führt bereits die im Jahr 2009 ausgerufene europäische Strategic Research Agenda

Es geht vielmehr um die Unterstützung von Mitarbeitern in kleinen und mittelständischen Unternehmen, deren Auftragslage sich relativ schnell ändern kann. Denkbar ist die Fertigung von Prototypen, von denen häufig nur geringe, einstellige Stückzahlen gefertigt werden. In diesem Kontext sind zur Zeit Handarbeitsplätze immer noch die Regel, d. h. Fachkräfte montieren und bearbeiten Bauteile bzw. bestücken und entladen Maschinen manuell. Häufig sind diese Arbeiten verbunden mit anstrengender körperlicher Arbeit.

Eine Vollautomatisierung im klassischen Sinne, also mit Robotern, die genau auf diesen einen Zweck ausgelegt sind und in aller Regel nicht oder nur sehr aufwendig an neue Fertigungsaufgaben angepasst werden können, macht hier allein schon aus ökonomischen Gründen keinen Sinn. Der durch die Einsparung einer Fachkraft gewonnene finanzielle Vorteil wird sofort wieder zunichte gemacht durch den notwendigen, häufigen und kostenintensiven Einsatz von Experten, die den Roboter bei jeder Änderung im Produktionsablauf wieder an seine neue Aufgabe anpassen und umprogrammieren müssen. Zusätzlich sind viele Teilaufgaben in solchen Fertigungsprozessen sehr komplex und wenn überhaupt nur mit enorm hohem technischen Aufwand automatisch zu bewerkstelligen, wie z. B. der berühmte Griff in die Kiste

Die Idee ist vielmehr, den Menschen zu unterstützen, indem man ihm diejenigen Arbeiten überlässt, die er z. B. auf Grund besserer visueller Wahrnehmung und guten Fingerfertigkeiten kompetenter und schneller durchführen kann als jede Maschine, ihn aber durch den Roboterassistenten von körperlich belastenden Arbeiten zu befreien … der Roboter als dritte Hand. Damit jedoch beide, Roboter und Mensch, an einem Arbeitsplatz gemeinsam sinnvoll zusammenarbeiten können, sind einige Herausforderungen zu bewältigen. Ein bisschen Buzzword-Bingo:

Flexibilität: Um sich den ständig wechselnden Aufgaben anpassen zu können und in beliebigen (engen, eingeschränkten) Arbeitsräumen mit dem Menschen zusammen zu arbeiten, ist im Vergleich zu herkömmlichen Industrierobotern zusätzliche Flexibilität nötig. Diese erhält man z. B. durch zusätzliche Bewegungsachsen: übliche Industrieroboter verfügen über bis zu sechs Achsen, ab sieben Achsen erhält man durch Redundanz zusätzliche Flexibilität.

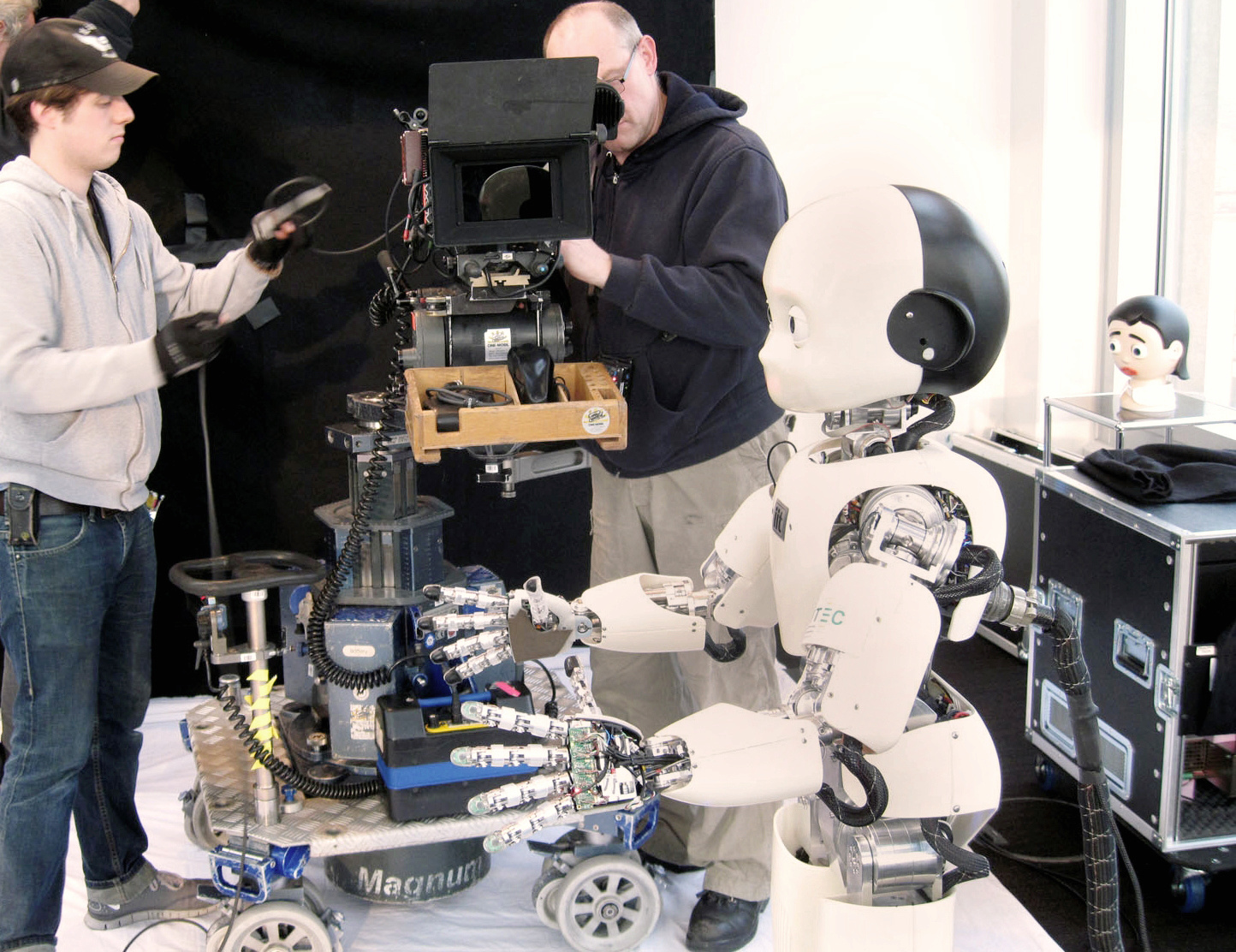

Technisch gesehen scheinen obige Herausforderungen so gut wie gelöst. Der vom Deutschen Luft- und Raumfahrtszentrum

Dass trotzdem nun nicht jeder sofort einem solchen Roboter Aufgaben beibringen kann, sieht man im folgenden Video, welches im Verlaufe einer umfangreichen Feldstudie 1 mit Mitarbeitern der Firma Harting

Die Aufgabe für die Probanden bestand im Prinzip aus einer Art Heißer-Draht-Spiel:

Der vorn am Roboter montierte Greifer sollte möglichst genau an dem Styropor-Parcours entlang geführt werden, währenddessen natürlich jede Kollision sowohl vorne am Greifer als auch am Rest des Roboterkörpers mit den Umgebungsobjekten vermieden werden sollte. Der Hintergrund: Genau durch diese Art des Führens (englisch: Kinesthetic Teaching) können dem Roboter Aufgaben beigebracht werden. Die in der Interaktion entstandenen Bewegungen werden aufgezeichnet und können auf Befehl schneller, langsamer oder leicht verändert wieder abgespielt werden. Der Fachbegriff hierfür lautet Teach-In und bezeichnet das aktuell übliche Verfahren, um Roboter „anzulernen“.

Wie man in dem Video sieht, geht das zum Teil gehörig schief! Die Versuchspersonen scheinen (trotz einer vorherigen Eingewöhungsphase mit dem Roboter) überfordert von der Aufgabe, dem LBR den Parcours kollisionsfrei beizubringen. Das liegt nicht an der Komplexität der Aufgabe: Eine einfache vorgegebene dreidimensionale Bewegung wie die des Parcours aus der Studie nachzufahren, ist für uns Menschen typischerweise zu bewältigen und wie wir später sehen werden auch in Verbindung mit einem Roboter leicht möglich. Der Grund ist die durch jahrelange Ingenieurskunst geschaffene, komplizierte Technik des LBR, die technische Vorteile, aber auch erhöhte Komplexität mit sich bringt. Denn hinter dem einen „I“ des Wortes „Interaktion“ verstecken sich noch zwei weitere: intuitiv und intelligent. Einem Roboterarm mit sieben Gelenken eine bestimmte dreidimensionale Bewegung beizubringen und dabei gleichzeitig darauf achten zu müssen, dass er mit seinen sieben Achsen nicht mit Hindernissen im Arbeitsraum kollidiert, ist nicht intuitiv. Und eine vorgemachte Bewegung abspeichern und wieder abspielen zu können, ist nicht sonderlich intelligent.

Dieses Beispiel zeigt, dass in der Praxis mehr notwendig ist als nur die technischen Möglichkeiten zu schaffen. Der Schlüssel, davon sind wir überzeugt, liegt in einer systematischen Integration von Hochtechnologie, maschinellem Lernen und einfacher Interaktion. Um ein solches Robotiksystem für den Arbeiter vor Ort bedienbar zu machen, muss die eigentliche technologische Komplexität im besten Fall hinter intuitiven Benutzerschnittstellen und schrittweiser Interaktion versteckt werden. Am Forschungsinstitut für Kognition und Robotik (CoR-Lab)

Der erste Teilschritt der Aufgabe heißt Konfigurationsphase und ist unabhängig von der Aufgabe, die der Roboterarm später ausführen soll. In dieser Phase bringt der Nutzer bzw. der Mitarbeiter dem Roboter seine neue Umgebung bei, d. h. eventuelle dauerhafte Hindernisse, welche in seinem Arbeitsbereich platziert sind, wie z. B. herumliegende Objekte, Säulen oder Regale. Als Mensch hat er dabei ein intuitives Verständnis der Szenerie: Er sieht die Hindernisse, er weiß, dass und wie man um sie herumgreifen muss und ist deswegen instinktiv in der Lage, den LBR dabei in ausgesuchte Regionen zu führen und dort mit ihm zusammen einige Beispielbewegungen durchzuführen, ohne mit den Hindernissen zu kollidieren. Von diesen Beispielbewegungen kann nun der Roboterarm lernen, wie er sich in seinem Arbeitsbereich zu bewegen und wie er die Hindernisse im Zweifel zu umgreifen hat. Die Methoden zum Lernen, die dabei verwendet werden, gehen über simples Aufnehmen und Reproduzieren hinaus. Mit Hilfe von künstlichen neuronalen Netzen ist das System nämlich nicht nur in der Lage sich innerhalb der trainierten Bereiche zu bewegen, sondern auch zwischen diesen hin- und her zu manövrieren und kollisionsfreie Bewegungen für den Arm zu wählen. Diese Eigenschaft von Lernverfahren nennt man Generalisierungsfähigkeit und beschreibt die Fähigkeit, von wenigen Beispieldaten ein generelles Verhalten zu erlernen und dieses auf unbekannte Daten zu übertragen. In unserem Fall sind die Beispieldaten die Trainingsdaten, welche vom Nutzer zur Verfügung gestellt werden und im Video als grüne Punkte dargestell sind. Von diesen lernt der Roboter innerhalb weniger Minuten, beliebige Zielpositionen anzufahren, ohne dabei mit den Hindernissen zu kollidieren. Und das nicht nur in den Trainingsbereichen, sondern auch darüber hinaus 2.

Im nächsten Schritt, geht es nun darum, ihm die eigentliche Aufgabe beizubringen. Das kann z. B. eine Schweiß- oder Klebenaht sein und auf verschiedenen Wegen passieren, z. B. erneut mit Hilfe von Kinesthetic Teaching, also dem direkten Führen des Roboters. Da dieser sich aber in seiner Umgebung nun schon zu bewegen weiß, braucht der Nutzer nicht mehr alle Gelenke gleichzeitig zu kontrollieren. Es reicht, dass er ihn vorn am Greifer entlang der spezifischen Aufgabe führt und der Roboter assistiert ihm dabei sozusagen bei der Hindernisvermeidung, wie in dem Video ab Minute 2:10 zu sehen ist. Diese Phase nennen wir deshalb Assisted Programming.

Der Knackpunkt zur Vereinfachung dieser Interaktion liegt also in der Aufteilung der Gesamtaufgabe in zwei oder mehr aufeinander aufbauende Teilschritte, um den Nutzer bzw. Mitarbeiter des Roboters nicht zu überfordern. Im letzten Jahr haben wir mit Unterstützung der Firma Harting oben genannte Pilotstudie zum Thema Kinesthetic Teaching durchgeführt und die beschriebene Idee evaluiert. Dabei haben 48 Mitarbeiter, unterteilt in zwei Versuchsgruppen, mit dem System interagiert und versucht, dem Roboter obigen Parcours beizubringen. Die Ergebnisse der einen Gruppe waren bereits im ersten Video zu sehen. Von 24 Versuchsteilnehmern, haben es gerade einmal zwei Probanden geschafft, den Parcours kollisionsfrei abzufahren; eine Probandin brach ihren Versuch nach einiger Zeit frustriert ab. Die zweite Versuchsgruppe hingegen benutzte den assistierten Modus und zeigte signifikant bessere Ergebnisse. Diese Teilnehmer benötigten im Schnitt weniger als die Hälfte der Zeit, um den Roboter anzulernen, die beigebrachten Bewegungen waren signifikant näher an der Vorgabe und wesentlich ruckelfreier.

Unsere Experimente und Studien legen nahe, dass moderne Robotiksysteme durchaus über die Flexibilität verfügen, regelmäßig und vor Ort an wechselnde Aufgaben angepasst zu werden, wie es zum Beispiel für Kleinserienfertigung oder Prototypenbau notwendig ist. Dazu reicht die rein technische Flexibilität allerdings nicht aus, denn sie erfordert immer noch lange Einarbeitung und Robotikexperten. Erst in der Kombination mit lernenden Systemen und einfachen Interaktionsschnittstellen spielen solche Systeme ihr volles Potential aus.