Disney hat seit diesem Monat eine neue Attraktion, sowas ähnliches wie ein Fahrgeschäft. Aber mit Robotern. Es nennt sich Sum of all Thrills (Die Summe aller Nervenkitzel) und steht im Walt Disney World Resort in Florida.

Das Prinzip ist bekannt, ein kräftiger Industrieroboter wirbelt zwei Personen auf Sitzen durch die Gegend. Die Bewegungen sind im Prinzip ähnlich der auf einer Achterbahn, durch die Bewegungsfreiheit der Roboter lassen sich allerdings weitaus wildere Bewegungen machen. Ein Beispiel:

Auch Legoland hat soetwas seit einiger Zeit. Disney bettet dieses Prinzip jetzt aber in ein etwas größeres Ereignis ein und macht es besonders auf:

Die vergnügungswilligen Passagiere haben während der Fahrt ein Display vor den Augen, das zu den Bewegungen des Roboters optisch eine Fahrt simuliert.

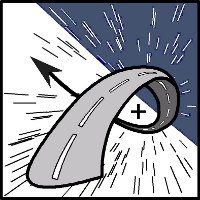

Toll und neu ist dabei auch das Bedienkonzept der Anlage, denn man darf sich selbst die Strecke zusammenbauen, die man mit dem Roboter fahren will. So kann man Schrauben, Loopings, Abfahrten, usw. … hintereinanderschalten und sogar pro Abschnitt Geschwindigkeit, Länge und Höhe der Bahn festlegen.

Aber nicht nur die Bahn kann konfiguriert werden, sondern es lässt sich außerdem entscheiden, mit welchem Gefährt man unterwegs sein will: Achterbahn, Bob oder Düsenjet.

Wie die Auswahl aussieht und sogar für Kinder bedienbar sein soll, zeigt das folgende Video:

Wichtiger Bestandteil des Systems ist natürlich ein Top-Simulator, der im Vorfeld der tatsächlichen Fahrt die frei wählbare Strecke am Industrieroboter simuliert und auf ihre Machbarkeit überprüft. Denn schließlich können bei jeder konfigurierten Strecke neue Bewegungen entstehen und bevor Menschen auf den Roboter gelassen werden, muss sichergestellt sein, dass der Roboter keine falschen Bewegungen ausführt. Denn diese Roboter sind unfassbar kräftig und dadurch mit Sicherheit zu Bewegungen fähig, die das Wohlbefinden der Passagiere weit überschreiten.

Technisch ist Sum of all Thrills übrigens ein KUKA RoboCoaster mit einem Handhabungsgewicht von 430 Kilogramm.

Eine tolle Idee, wie ich finde. Hier macht man sich sämtliche Freiheitsgrade des Industrieroboters in Kombination mit Display und der Bedienführung zunutze, um dem Besucher seine eigene Achterbahnfahrt ganz nach seinem Wunsch zu ermöglichen. Ich muss zugeben, dass ich das auch gerne machen würde.

Via Planet Robotics.