In knapp drei Tagen, am kommenden Dienstag startet in Istanbul an der Grenze zwischen Europa und Asien die RoboCup-Weltmeisterschaft 2011. Auch ein Team aus Bielefeld, ToBi (Team of Bielefeld) ist wieder in der RoboCup@Home-Liga dabei.

Ich habe deswegen die Gelegenheit des letzten Robotik-Stammtischs genutzt, um mit Frederic Siepmann, dem Verantwortlichen für das Bielefelder Team, ein wenig über den RoboCup und die Vorbereitungen dafür zu sprechen:

Ich: Hey Frederic. Ihr habt ja im letzten Jahr in Singapur den siebten Platz gemacht. Welche Unterschiede und Verbesserungen in diesem Jahr an Eurem System gibt es im Vergleich zum Vorjahr. Und sind überhaupt die Aufgaben wieder die gleichen?

Frederic: In diesem Jahr ist im Prinzip der selbe Funktionumfang wie im letzten Jahr gefordert. Es gibt immer einige kleine Änderungen an Aufgaben, in denen sich im vergangenen Jahr Probleme herausgestellt haben oder die Regeln nicht klar genug formuliert waren. Es hat sich auch ein bisschen etwas an der Punktevergabe geändert, aber im Prinzip sind es die selben Aufgaben.

Daher ist der Unterschied bei uns zum letzten Jahr vor allem, dass damals viele Sachen einfach mit der heißen Nadel gestrickt waren. Das konnten wir jetzt mal etwas intensiver testen und stabilisieren. Im Rahmen der @Home-Liga gibt es auch immer die sogenannte Demo Challenge. Dafür wird immer ein Thema vorgegeben und dort kann man dann im Prinzip tun, was man will. Es muss nur irgendwie in dieses Demo-Konzept passen. In Singapur im letzten Jahr war ein Restaurant-Kontext vorgegeben. Das heißt, wir haben zum Beispiel viel gesehen, dass der Roboter Bestellungen entgegennimmt und den Leuten Getränke bringt; wie man sich das eben von einen Roboter im Restaurant vorstellt. In diesem Jahr ist das Thema Household Cleaning vorgegeben. Da haben wir jetzt bei den German Open noch nicht so sehr viel gesehen, aber man sah, dass viele Roboter versuchen, Gegenstände vom Boden aufzusammeln und in den Müll zu schmeißen …

Ich: Ich glaube, ich habe auch gesehen, wie einer der Roboter versucht hat, mit einem Lappen einen Tisch sauberzumachen …

Frederic: Ja, genau. Das waren wir.

Ich: Ach, das wart Ihr. Und das werdet Ihr auch in Istanbul zeigen?

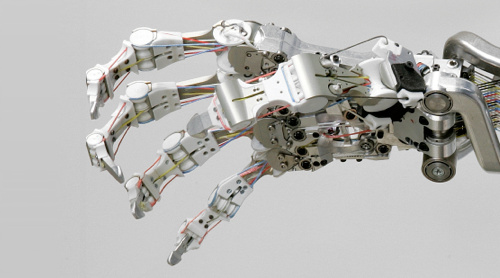

Frederic: Ja, wir werden mit Sicherheit wieder Tischsäubern zeigen. Wie Du ja weißt, ist die Plattform bei uns ja etwas eingeschränkt, da der Arm nicht soweit herauskommt. Aber wir haben jetzt noch ein paar Extra-Gimmicks eingebaut, zum Beispiel dass der Roboter jetzt dynamisch die Flächen erkennen kann und man dem Roboter zeigen kann, wo er reinigen soll. Es ist für den Roboter natürlich schwierig zu erkennen, wie schmutzig eine Fläche ist. Wenn da Konfetti liegen ist das noch okay, aber bei Staub wird es schon schwierig. Man muss da noch etwas sehen, welche Szenarien da denkbar sind, aber im Prinzip passt das.

Ich: Ihr wart ja im April bei den German Open und habt glaube ich den dritten Platz gemacht …

Frederic: Nee, nach der Vorrunde waren wir zwar auf dem dritten Platz, sind dann im Finale aber noch von den b-it-bots abgefangen worden.

Ich: Ein vierter Platz, mit dem Ihr zufrieden wart?

Frederic: Ja, auf jeden Fall.

Ich: Ich nehme aber an, dass Ihr auch von dort noch Dinge mitgenommen habt, die noch zu verbessern sind?

Frederic: Ja. Die German Open – und vermutlich alle nationalen Vorentscheide – sind immer so ein bisschen ein erster Test Case. Da hat man dann normalerweise zum ersten Mal on site wirklich Zeit, das System intensiv zu testen. Die Studenten bekommen dann auch zum ersten Mal wirklich mit, wie das ist: Wenn es dann wirklich auf Kommando losgehen soll, hektisch ist und die Hardware überall herumfliegt usw. … von daher ist das ein super Testszenario, das würde ich auch nicht missen wollen.

Ich: Zum ersten Mal auch unter den echten Wettkampfbedingungen …

Frederic: Richtig! Man muss dann auch zum ersten Mal richtig in die Arena hereinfahren und dann stehen dort Objekte und Möbel herum, die man nicht erkennen kann. Man kann sich dann auch wirklich intensiv und mit viel Zeit um den Roboter kümmern, da ja dann auch das gesamte Team da ist. In der Uni mischen sich dann ja auch immer viele andere Dinge dazu. Das hat uns auch wieder ziemlich viel gebracht in diesem Jahr. Wir konnten viele Dinge für die weitere Arbeit in unserem Wiki festhalten: Dinge, die gut und Dinge, die nicht so gut gelaufen sind und die wir noch verbessern wollen.

Ich: Seit wievielen Jahren seit Ihr jetzt mit Eurem System beim RoboCup@Home vertreten?

Frederic: Tatsächlich erst seit 2009. Damals sind wir aus dem Stand auf den achten Platz gekommen, was ziemlich gut war. Im letzten Jahr sind wir dann wie gesagt Siebter geworden, dieses Jahr werden wir sehen, was passiert.

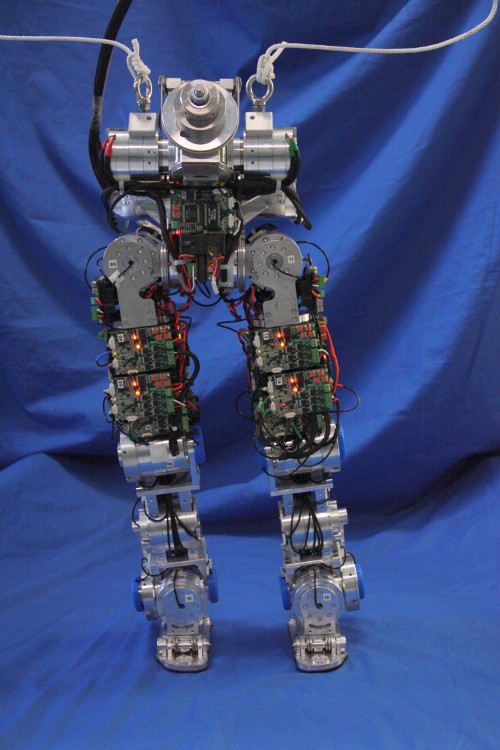

Ich: War das damals die gleiche Plattform wie in diesem Jahr?

Frederic: Ja gut, wir haben die seitdem natürlich etwas modifiziert, aber die Basis ist die gleiche geblieben. Wir hatten damals die neue Plattform bekommen und in dem Rahmen beschlossen, dass die Teilnahme an der @Home-Liga eine brauchbare Sache wäre. Diese Liga hat eben Anforderungen, die unserer sonstigen Forschung insgesamt schon recht ähnlich sind. Das erste Team hat natürlich erst einmal die meiste Arbeit, weil einige der Basiskomponenten einfach noch nicht für die Plattform zur Verfügung standen. SLAM zum Beispiel musste erst einmal darauf gebracht werden. Oder Objekterkennung. Das war zwar schon vorhanden, aber eben noch nicht auf dieses Robotersystem portiert. Das war viel Arbeit zu Beginn.

Ich: Kommen bei Euch denn jetzt eigentlich auch im Vergleich zur German Open noch weitere Features dazu?

Frederic: Stabilität ist natürlich auch ein Feature. (lacht) Wir haben aber tatsächlich auch noch ein wenig grundlegend an der Software gearbeitet. Zum Beispiel die Ansteuerung des Arms und die Objekterkennung verbessert. Das heißt, da können wir jetzt auch noch etwas mehr als bei den German Open.

Das klassiche Problem ist ja zum Beispiel, dass wenn man ein Objekt erkannt hat, man den Roboter erst einmal so positionieren muss, dass der Arm das Objekt überhaupt greifen kann. Das stellt sich im Moment noch etwas als Schwierigkeit heraus. Die Software haben wir schon, sie ist aktuell aber einfach noch nicht vollständig ins System integriert.

Ich: Also Frederic, ich nehme an, Deine letzten Wochen waren deutlich von der Arbeit für den RoboCup bestimmt?

Frederic: Das würde ich sofort unterschreiben, ja!

Ich: Das kostet ja insgesamt schon ziemlich viel Zeit, insbesondere natürlich in der Vorbereitung eines Turniers. Inwiefern, würdest Du sagen, profitiert da ein Institut oder vielleicht sogar Du als Wissenschaftler von?

Frederic: Super Frage! Also bei uns ist es ja tatsächlich so, dass ca. 90 Prozent der Teammitglieder jedes Jahr wechseln. Da kommen also jedes Jahr frische, neue Studenten, die an dem Roboter arbeiten wollen. Das ist mit Sicherheit auch etwas Besonderes von dem Bielefelder Team, was natürlich auch besondere Anforderungen an die Entwicklungsumgebung stellt. Wir machen das aber natürlich sehr gerne, weil wir dadurch sehr früh die Studenten mitnehmen können. Von der universitären Seite ist natürlich sehr spannend, dass wir die Studenten so sehr früh in unsere Software einführen können. Die können dann damit wirklich coole Sachen machen, wir haben zum Beispiel unheimlich viele studentische Abschlussarbeiten im Rahmen unserer RoboCup-Teilnahme. Außerdem kommen so auch immer wieder Studenten als Hilfswissenschaftler zu uns. Davon kann natürlich die Universität und das Institut ganz enorm profitieren. Einfach auch weil wir damit natürlich auch viel Manpower dazugewinnen.

Das System als solches, das wir in dem Rahmen entwickeln, und die Entwicklung, die man in der Kürze der Zeit damit macht, würde man wahrscheinlich sonst auch in der Form nicht hinbekommen.

Ich: … wegen der fokussierten Arbeit an einer lauffähigen und stabilen Version …

Frederic: Genau! Also, man mag mir da widersprechen, aber es ist sonst im universitären Umfeld auch nicht so häufig, dass so stark in Richtung eines Systems gearbeitet wird, das wirklich stabil auf einer Plattform läuft.

In wissenschlaftlicher Hinsicht ist der RoboCup immer durchaus zwiespältig diskutiert. Einige sagen, dass die Verfahren einfach schon seit Jahren bekannt sind und es im Prinzip nur darum geht, die schnellere Hardware zu haben. Zum Teil ist das sicherlich auch berechtigt und mag stimmen. Gerade beim Roboterfußball hört man das häufig.

Bei der @Home-Liga trifft das sicherlich nicht so sehr zu. Da lässt sich durch schnellere Hardware nicht so viel wettmachen, weil viele Probleme hier einfach auch noch nicht gelöst sind.

Ich: In der @Home-Liga passiert also auch noch mehr Forschung, würdest Du sagen? Weil es da auch konzeptionell noch mangelt?

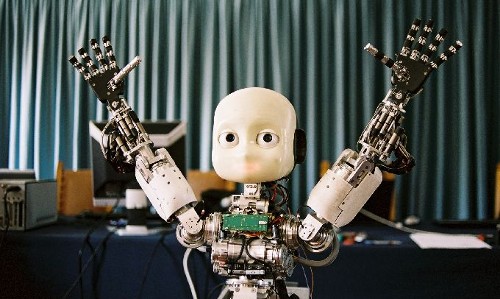

Frederic: Die @Home-Liga ist auch einfach noch eine der jüngsten Ligen des RoboCup, ich glaube erst 2005 gegründet worden, und seitdem die am stärksten wachsende Liga. Und die Teilnehmer, ob jetzt Georgia Tech, University of Tokio, Osaka University, Bielefeld und einige andere … das sind Namen, die man durchaus auch im Forschungsumfeld viel hört.

Es sind einfach auch viele Probleme wirklich noch ungelöst. Daher würde ich schon sagen, dass wenn man Forschung in diesem Bereich macht – was Grundvoraussetzung ist – kann man da durchaus von profitieren. Auch, da man dadurch ja Systeme bekommt, mit denen man dann empirische Daten aufnehmen kann. Häufig hat man eben in der Robotik einzelne Komponenten, aber ohne lauffähiges Gesamtsystem kann man keine vernünftigen Tests machen. Das Problem haben wir nicht.

Ich: Du würdest also sagen, dass Du auch als Wissenschaftler davon profitierst?

Frederic: Vielleicht nicht so viel wie ich könnte, aber im Prinzip auf jeden Fall, ja.

Ich: Und ich nehme an, du würdest Studenten in der Robotik auch jederzeit empfehlen, an solchen Wettbewerben teilzunehmen, sofern die Möglichkeit an der Universität oder dem Institut besteht?

Frederic: In meinen Augen ist das das beste, was man machen kann. Das ist das echte Entwicklerleben und nicht die berühmte trockene Theorie, die einem ja sonst häufig in der Informatik vorgeworfen wird. Das einmal mitgemacht zu haben, ist auch wirklich ein Erlebnis. Kann natürlich auch sehr frustrieren sein, wenn es nicht funktioniert. Aber wenn man dann dazu beigetragen hat, einen Platz XY bei der Weltmeisterschaft zu machen und Sachen, die man selbst programmiert hat vor einem Publikum präsentieren kann und der Roboter räumt dann richtig ab … das ist einfach nur genial!

Ich: Okay, Frederic. Danke vielmals für den ausführlichen Einblick und viel Erfolg mit Team ToBi in Istanbul!

Frederic: Danke.

Das Team ToBi bloggt übrigens auch fleißig über den Turnierverlauf und die Vorbereitungen. Frederic Siepmann ist Diplom-Informatiker am Center of Excellence Cognitive Interaction Technology (CITEC) in Bielefeld und seit 2008 Teamlader des Team ToBi.