In der letzten Zeit habe ich einige Male über den iCub geschrieben. Das liegt zum Einen daran, dass ich bekennender iCub-Fan bin und zum Anderen daran, dass ich in letzter Zeit immer häufiger von Arbeitswegen mit ihm in Berührung komme. Endlich finde ich nun die Zeit, mal über eine neue Entwicklung des iCub zu schreiben, die ich schon seit einigen Monaten mit Spannung verfolge und zu der ich jetzt auch Bilder und Videos aus erster Hand zeigen kann: Die neuen Beine des iCub.

Der iCub ist im Rahmen des RobotCub-Projekts seit 2004 entstanden und wird seitdem kontinuierlich weiterentwickelt. Hauptsächlich bezog sich dies in den letzten Jahren auf Weiterentwicklung der Firmware und der iCub-Softwareumgebung, um die vorhandene Hardware immer besser, effektiver und einfacher nutzen zu können. Da der iCub als humanoide Forschungsplattform aber so erfolgreich ist, wird er konsequenterweise auch in Sachen Hardware weiterentwickelt. Kopf, Hände, Arme, Beine … für nahezu alle Teile existieren mehr oder weniger fortgeschrittene Pläne und Ansätze zur Weiterentwicklung.

Am CoR-Lab arbeiten wir zur Zeit noch mit der ersten Version des iCub, auf der Summer School jedoch durfte ich schon mit einer weiterentwickelten Version des iCub arbeiten, die über Kraftsensorik in Armen und Beinen verfügt. Diese Kraftsensoren können (noch relativ grob) Kontaktkräfte messen, die auf Arme und Beine einwirken. So erlaubt diese iCub-Version zum Beispiel, dass man den iCub bei der Hand nimmt und seinen Arm führt; ein bedeutender Fortschritt in der Interaktion von Mensch und Roboter, wenn man ihn anfassen und führen kann. Eine weitere faszinierende Möglichkeit ist, den Roboter in einen Nachgiebigkeits-Modus zu schalten. In diesem Modus reagiert der Roboter auf die Kräfte, die auf ihn wirken, auf die gleiche Art, wie es eine Feder tun würde: Bei kleiner Krafteinwirkung gibt der Roboter ein wenig nach, bei größerer Krafteinwirkung gibt der Roboter deutlicher nach. Der Roboter fühlt sich dadurch sanft und weich an. Dieser Modus, diese Art der Regelung, nennt sich Active Compliance (aktive Nachgiebigkeit). Ein Video mit dieser iCub-Version zeigt, wie Ugo diese Eigenschaften nutzt, um den iCub mit Spielzeug vertraut zu machen:

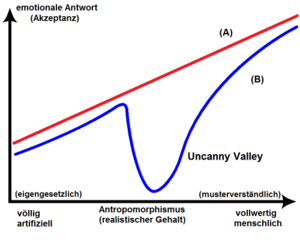

Bei meinem Besuch am IIT (Italien Institute of Technology in Genua) an einem Tag während der Summer School habe ich eine iCub-Version kennengelernt, die für das AMARSi-Projekt entwickelt wird und dieses Konzept noch weiter treibt. Dieser iCub (der vielleicht irgendwann einmal auf den Namen cCub, Compliant iCub, hören wird), hat nicht nur wie sein Vorgänger in Armen und Beinen jeweils einen Kraftsensor, sondern er verfügt über neue Gelenke, die jeweils sowohl weitere Kraftsensorik als auch echte mechanische Federn integrieren. Was diese integrierten Gelenk-Module in dem Betrachter auszulösen vermögen, wenn sich der iCub damit bewegt, ist eine der faszinierendsten Dinge, die ich in letzter Zeit in der Robotik gesehen habe. Die Kombination aus Active Compliance, also der durch Sensorik und Regelung simulierten Nachgiebigkeit, mit der realen Nachgiebigkeit der eingebauten mechanischen Fähigkeiten (Passive Compliance), bewirkt eine Natürlichkeit der Bewegung des Roboters, die im ersten Moment irritierend bis verstörend wirken kann.

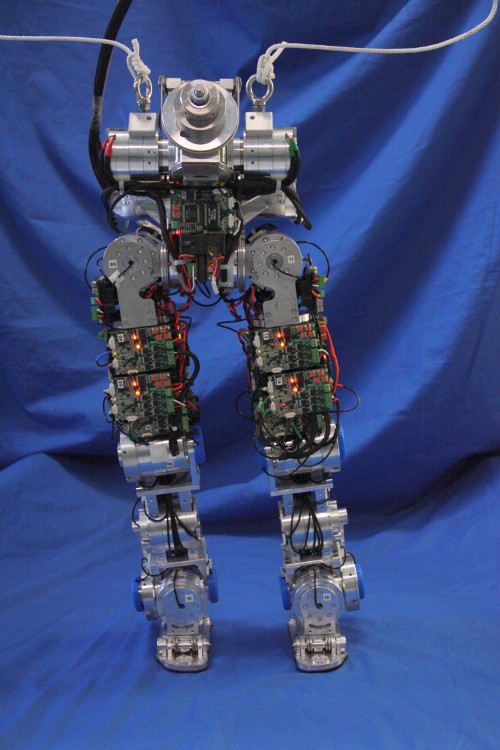

Active Compliance allein macht die Interaktion mit dem Roboter schon deutlich natürlicher, und Bewegungen sehen weicher, runder und natürlicher aus. Nichtsdestotrotz bleibt der Eindruck beim Betrachter, dass es sich – tatsächlich – nach wie vor um eine Maschine handelt. Und genau dieser Eindruck scheint in dem Moment zu verschwinden, in dem zu der aktiven Nachgiebigkeit die echte (passive) Nachgiebigkeit der mechanischen Federung hinzukommt. Der Roboter bewegt sich damit offenbar in einer Art und Weise mit unterbewusst wahrgenommenen Schwingungen, die im menschlichen Hirn den Eindruck erwecken, hier würde sich ein biologisches Körperteil bewegen. Die mechanische Federung scheint ein ähnliches Muster aus Schwingungen und Oberschwingungen zu erzeugen, wie es menschliche Muskeln und Sehnen tun. Für mich war dies ein faszinierender, erschreckender Moment – als Robotiker allerdings positiv, was vermutlich nicht jedem Betrachter so ergeht. Nikos Tsagarakis, dessen Gruppe am IIT diese integrierten nachgiebigen Gelenke des iCub entwickelt, hat mir Fotos und Videos zugesandt und mir erlaubt, diese hier im Blog zu veröffentlichen. Zu sehen sind im folgenden Video die neuen Beine (noch ohne Oberkörper), wie sie balancieren und kleine Schritte tun. Ich weiß nicht, wie gut der beschriebene Effekt im Video erkennbar ist, wenn man ihn nicht live erlebt, aber dies ist der Versuch:

Wer dies im Video nicht zu erkennen vermag, erfreut sich vielleicht an der Vorstellung des vergangenen AMARSi-Projekttreffens, als bei der Live-Demo dieser Beine grob geschätzt 40 Wissenschaftler, die in ihrem Leben schon hunderte Roboter gesehen haben, schweigend und mit großen Augen minutenlang diesen Beinen bei ihrer einfachen Bewegung zusahen.

Und hier die Beine nochmal in der Großaufnahme:

Technisch Interessierte finden eine detailliertere Beschreibung dieser integrierten Aktuatoren in der Konferenzbeitrag zur ICRA 2009: A Compact Soft Actuator Unit for Small Scale Human Friendly Robots (kostenpflichtiger Zugriff via IEEE). Die weitere Entwicklung dieser iCub-Version wird weiterhin auf der Website des AMARSi-Projekts dokumentiert.