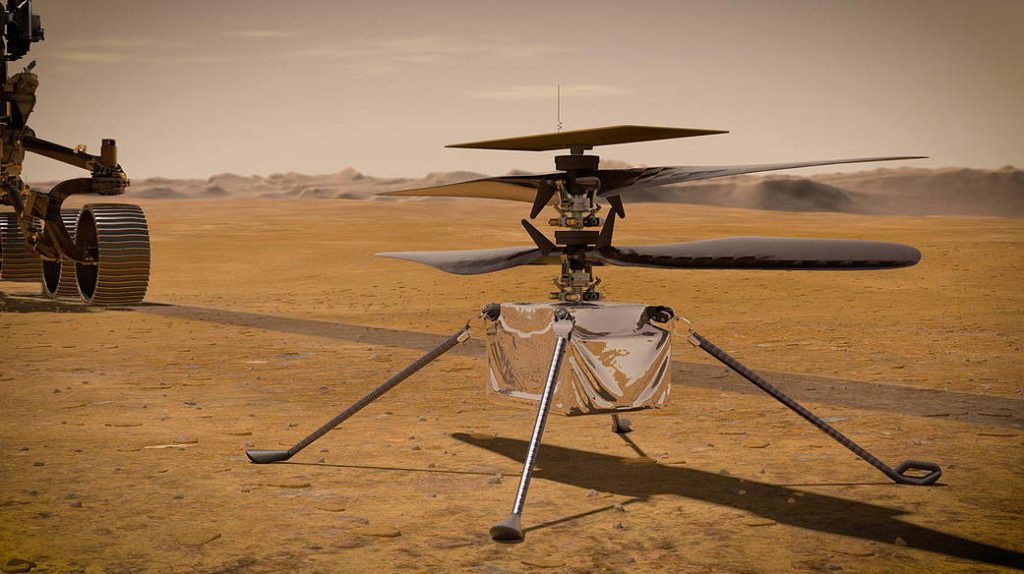

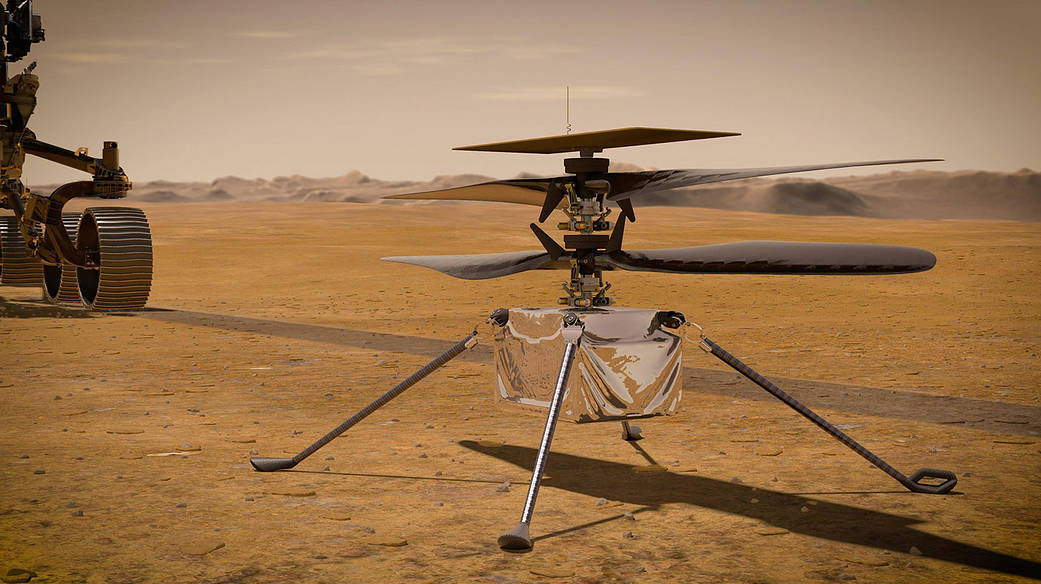

Der neue Mars-Rover Perseverance ist ein insgesamt technisch spannendes Gerät mit viel neuer Technik, um den Mars zu untersuchen. Richtig verrückt ist allerdings die Tatsache, dass der Rover eine kleine Drohne, den kleinen Helikopter Ingenuity, mit sich trägt. Der einzige Grund: Fliegen.

Im Gegensatz zum Mars-Rover soll der Helikopter nämlich keine Untersuchungen machen oder wichtige Ergebnisse bringen. Bilder von den Erkundungsflügen sind ein optionaler Pluspunkt. Nein, es geht bei dem Helikopter im Wesentlichen wirklich darum, zu zeigen, dass man auf dem Mars fliegen kann. Das ist nämlich aufgrund widriger Umstände ziemlich schwierig: nur 1 % Atmosphäre im Vergleich zur Erde, Energieversorgung wegen des dadurch notwendigerweise geringen Gewichts, Kommunikation mit dem Roboter, etc.

Die Größe des Körpers von Ingenuity ist kleiner als ein Schuhkarton. Er hat zwei vierblättrige Karbonfaser-Rotoren mit 1,2 Meter Durchmesser und insgesamt ein Gewicht von 1,8 kg. Er hat auch deutsche Technik an Bord, MEMS-Sensoren von Bosch zur Stabilisierung des Flugs. Wenn der Flug damit funktioniert, ist Ingenuity der erste Helikopter, der auf dem Mars fliegt und gleichzeitig das erste Fluggerät1 auf einem Planeten abseits der Erde.

heise.de hat schon vor einiger Zeit ein Interview mit dem „Piloten“ des Helikopters geführt: Interview: „Wir wollen zeigen, dass ein Hubschrauber auf dem Mars fliegen kann“. Und hier gibt es einen dreiviertel-stündigen Tech Talk der NASA zu „Helikoptern im Weltraum“:

Der Erstflug des Helikopters und damit der Erstflug eines mensch-gemachten Fluggeräts auf einem anderen Planeten ist aktuell für den 11. April geplant. Da die NASA von „end of the day on April 11“ spricht, könnte das seeehr spät oder bei uns sogar schon der frühe 12. April werden. Der Helikopter hat sich übrigens schon erfolgreich gemeldet, sitzt schon frei auf dem Marsboden und hat seinen Rotor schon erfolgreich bewegt. Bislang sieht es also gut aus! Update: ist mittlerweile für den 14. April geplant. Update: ist erneut verschoben worden, auf kommende Woche. Wegen eines Problems beim High-Speed Spin Test, wird es für Ingenuity erst einmal ein Software Update geben.

Der erste Flugversuch lässt sich wahrscheinlich wieder gut über den Twitter-Kanal des NASA JPL verfolgen. Vielleicht gibt es ja auch wieder einen Live-Stream.

Disclaimer: Der Autor dieses Beitrags ist Mitarbeiter der Robert Bosch GmbH. Die Inhalte des Blogs vertreten ausschließlich Meinungen und Ansichten des Blog-Betreibers und sind nicht als Unternehmensmeinung zu verstehen.

Berechnung zum Marshelikopter „Ingenuity“

Vor vier Jahren (am 04.04.2017) wurde in der 3sat-Sendung nano bereits der Mars-Helikopter mit seinen wichtigsten Parameter vorgestellt. Die technisch-physikalische Rekonstruktion und mathematische Berechnung ergab damals, dass der Helikopter aufgrund des zu geringen Auftriebes nicht auf dem Mars abheben und fliegen konnte (die Redaktion wurde damals über den Sachverhalt informiert). Übrigens wurde hier ein Auftriebsbeiwert cw von 1,5 angenommen, der natürlich Nonsens ist, da cw maximal 1 annehmen kann. Aus diesem Grund wurde mit den aktuellen Parametern nochmals (siehe Internet) mathematisch-physikalisch überprüft, ob der Heli überhaupt auf dem Marx abheben konnte.

1.Die relevanten Parameter des Marshelikopters

1.1.UR= 2530 U/min ≈ 21 U/s;

1.2. Gewicht GM auf dem Mars GM= 1,8 kg*3,71 m/s²= 6,68 N

1.3. Länge der vier Rotorblätter:1,2 m

1.4. VRotor= 3,14*1,2*2530 m/s:60*2= 79 m/s

1.5. Dichte ς der Atmosphäre auf dem Mars ς= 0,013 kg/m³

2. Berechnung des Auftriebes

Der Auftrieb berechnet sich zu:

F=ς*v²*A*cw: 2. (1)

Der Auftriebsbeiwert cw bei Hubschraubern liegt zwischen 0,3 bis 0,7. Das Optimum beträgt dabei 0,55 (siehe Fachliteratur). Der Schub/der Hub der Rotorblätter muss größer als das zu transportierende Gewicht GM betragen. Die Fläche der vier Rotorblätter soll 0,5 m² betragen. Damit beträgt der Auftrieb

F= 0,013 kg/m³ *79 m²/s²* 0,5 m²*0,55:2 =11,2 N. (2)

Damit ist der Auftrieb mit F= 11,2 N bedeutend größer als das Gewicht GM des Helis mit 6,7 N. Damit funktioniert die Drohne prinzipiell und kann in jedem Falle abheben und fliegen! Der Bericht der nasa entspricht also der Wahrheit.

Siegfried Marquardt, Königs Wusterhausen

Danke für die ausführliche Rechnung, Siegfried! Die Rechnung zeigt, dass die NASA hier ziemlich konservativ geplant hat (fast Faktor 2), um sicher zu sein. Sicherlich sinnvoll, wenn das Experiment so teuer ist und nicht leicht zu wiederholen. 😉

Willst Du mit der Rechnung Stimmen Wind aus den Segeln nehmen, die den Flug für gefälscht halten?